本篇文章將深入淺出地為你解釋什麼是 Token、什麼是上下文長度限制,以及如何有效避免超出限制,進而提升使用 ChatGPT 的整體體驗與效率。

什麼是 Token?

在 ChatGPT 或其他語言模型中,「Token」是 AI 模型理解與處理語言的基本單位。這個單位並不一定是字或詞,而是模型經過拆解後可以處理的片段。也就是說,Token 是機器理解語言的切割點。

- 一個中文字通常等於 1 個 token。

- 一個英文單詞(例如 how、are、you)也大約等於 1 個 token。

舉例來說:

- 中文句子:「你好嗎?」 → 約為 3 個 token

- 英文句子:”How are you?” → 約為 4 個 token

每次你和 ChatGPT 對話,不管是輸入的內容還是 AI 回覆的語句,背後其實都是以 token 為單位在計算,而不是單純的字數。這個計算方式會影響系統處理訊息的能力,也會影響你整體的對話流暢度與延續性。

上下文長度限制是什麼?

每一次與 ChatGPT 對話的過程中,模型都會持續「記住」你講過的內容以及它自己先前的回答,這整段歷史紀錄就叫做「上下文」(context)。這些上下文能讓 AI 更貼近你前後語意,並產生更精準的回應。

然而,這段上下文的長度是有「token 上限」的,每種模型的限制如下:

- GPT-3.5:約 4,096 tokens

- GPT-4:約 8,192 tokens

- GPT-4 Turbo(ChatGPT Plus 使用者所用版本):最高可達 128,000 tokens

當你的對話越來越長,或者每次貼上的內容太多,這些 token 就會不斷堆加,直到突破模型能處理的上限。一旦超過,就可能導致系統忘記前面的內容,甚至出現錯誤訊息或答非所問的情況。

額度不足的意思是什麼?

當你覺得視窗跑起來變慢、很常當掉,或是看到以下提示:

- 「視窗額度不足」

- 「超出 token 限制」

這通常代表:

- 當前對話視窗的內容總 token 數已經太多,超過了模型的記憶上限。

- 系統為了維持效能與反應速度,可能會自動捨棄早期的上下文記憶。

- 有時候必須手動開啟新對話,才能恢復正常操作與記憶。

如果你長時間持續在同一個聊天室中對話,會發現 ChatGPT 的反應速度明顯變慢。有些使用者也觀察到,在接近 token 上限時,特別是透過手機瀏覽器使用 ChatGPT,畫面可能會出現閃爍或跳段的情況,導致閱讀體驗不佳。

此時你可以主動問 ChatGPT:「這個對話距離 token 上限還剩多少餘裕?」它會告訴你剩餘可用的 token 數量,並建議你是否該開始新的對話或刪減上下文內容。

如何避免超出 Token 限制?

為了提升使用效率並避免中斷,以下是幾個實用技巧幫助你更好地管理 Token 使用:

- 精簡訊息內容:避免一次性貼上太大量資料,如長篇文章、逐字稿、技術文件或程式碼。

- 定期開啟新對話:當對話視窗內容過長時,主動開啟新的視窗,有助於清除累積的上下文。

- 利用檔案上傳功能:若你啟用了檔案上傳功能,將大篇幅內容放入文件中上傳,能有效減少貼文 token 數量。

- 角色與設定統一管理:針對需要 AI 長期記憶或角色扮演場景,建議使用 JSON 或範本方式統一設計,避免重複輸入造成資源浪費。

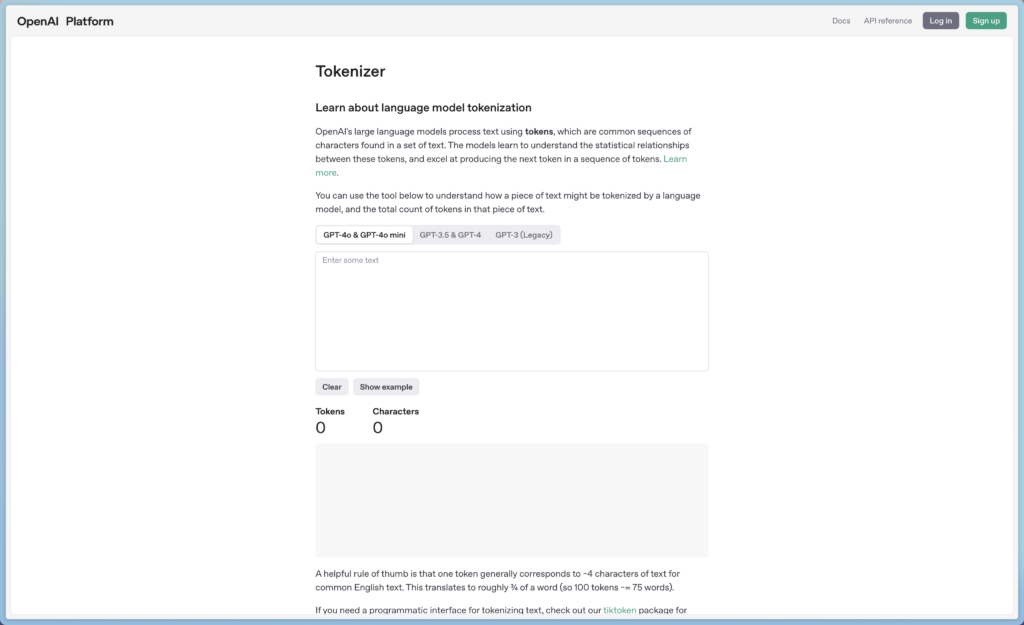

如何計算 Token?推薦工具

你可以透過 OpenAI 官方提供的 token 計算器來估算輸入文字所需消耗的 token 數量:

網址:https://platform.openai.com/tokenizer

這個工具可以讓你預先檢查內容長度,方便控制輸入量,讓每次對話更加順利無阻。

Token 是與 AI 模型互動時一個非常關鍵卻容易被忽略的概念。了解它的運作方式,能幫助你避免系統錯誤與溝通斷裂,並有效延伸 AI 的應用可能。透過控制輸入長度、合理切分資料、活用檔案上傳與定期清空對話等技巧,不僅能提升效率,也能讓你與 ChatGPT 的每一次對話更加精準且順暢。

記得適時詢問 ChatGPT 本次對話的 token 剩餘量,避免因超出限制而導致功能異常或反應延遲,尤其在長時間對話或進行專案討論時,這樣的小技巧會幫助你掌握使用節奏與品質。